Недавнее приобретение Apple в виде Vocal IQ, компании по разработке искусственного интеллекта, которая специализируется на голосовых программах, кажется не просто приобретением в стиле «потому что мы можем»: это вполне разумный шаг для развития способностей Siri. Также это еще одно свидетельство того, что роль ИИ в нашей повседневной жизни растет. И хотя опасения и обещания со стороны ИИ далеко не новы, достижения технологий усугубляют их все больше.

«Этот момент, когда вы говорите со своим компьютером, как в «Звездном пути», и он полностью понимает и выполняет ваши команды, должен стать реальностью в ближайшие 5 лет», — недавно заявил Антуан Блондо, генеральный директор Sentient Technologies Holdings, отметив также, что ожидает «массивные выгоды» для эффективности человека вследствие искусственного интеллекта, особенно в области здравоохранения, финансов, логистики и розничной торговли.

Далее Блондо предвидит рост «эволюционно разумных агентов», то есть компьютеров, которые «развиваются самостоятельно — обученные выживать и процветать за счет написания собственного кода — и создают триллионы компьютерных программ для решения невероятно сложных проблем».

И пока энтузиасты Кремниевой долины приветствуют потенциальные выгоды от искусственного интеллекта для человеческой эффективности и общественного блага, Голливуд раздувает его угрозы. Враг в лице ИИ привлекает сценаристов еще с «Космической Одиссеи 2001 года». 2015 год стал годом сбоев в киношных ИИ с такими фильмами, как «Терминатор: Генезис», «Из машины» и «Мстители: Эра Альтрона».

Но остаются ли риски ИИ в области скептиков и кинематографистов, или же действительно есть поводы для тревоги? Кремниевая долина не может получить «экспоненциальный» технологический рост и просто ждет положительных итогов. Точно так же, противники технологии не могут оттянуть взросление ИИ, хотя он и далек от того, что мы видим в фильмах.

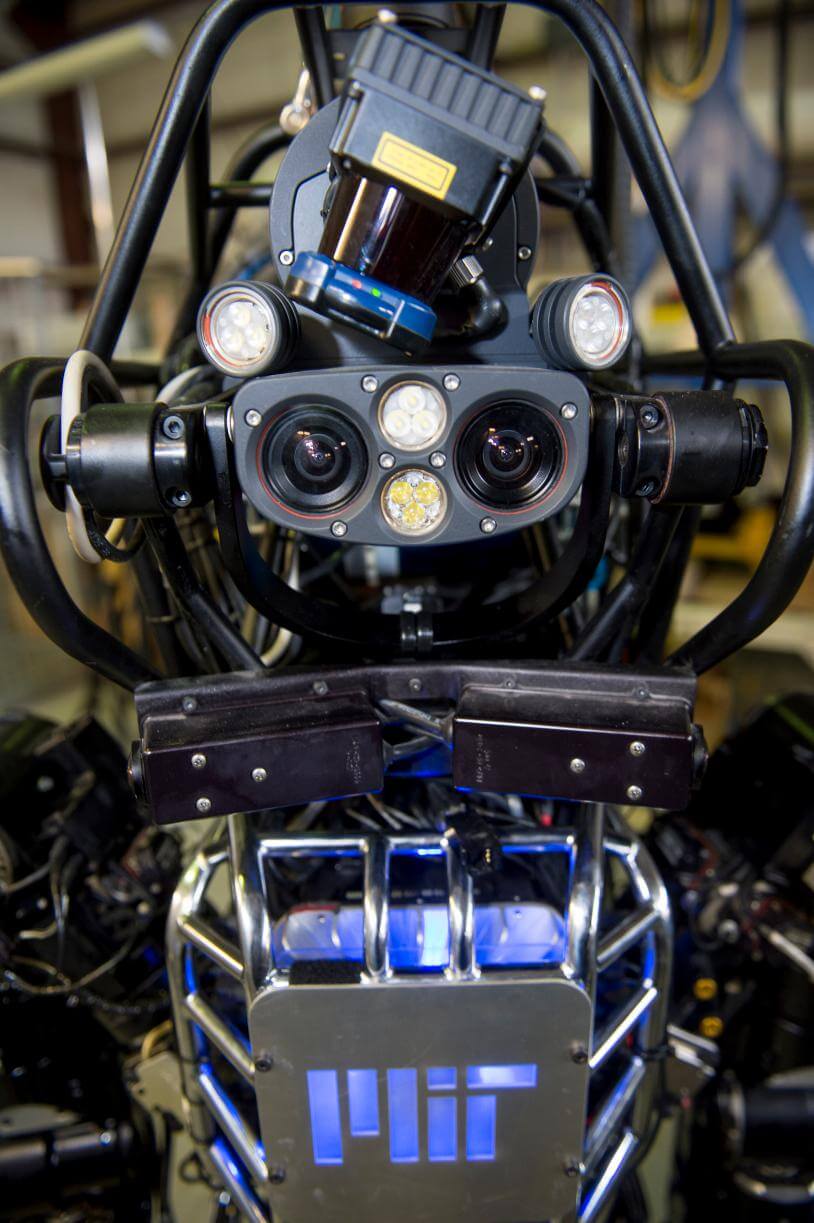

Робот Atlas

Темпы развития ИИ требует разговора, в котором будут участвовать лидеры среди технологов и политиков, специалисты по этике, законам и машинам, к которым мы привыкли в повседневной жизни и которые скоро выйдут за пределы решения рутинных задач. Однако этому разговору нужно уделять внимание не только на экране кино.

К примеру, даже если суперкомпьютер будет безупречно кодировать, будет самоорганизован и защищен от заражения воинственным государством, хакером или сердитым подростком, ИИ все еще может выдавать неправильные ответы. В январе 2015 года в журнале Wired появилась статья, в которой описывается, как ИИ может ошибаться. При виде параллельных желтых и черных горизонтальных линий, лучший из современных ИИ видит школьный автобус и уверен на 99% в своей правоте.

Насколько мы можем доверять ИИ, который возьмет контроль над «Интернетом вещей», будет принимать за нас решения относительно нашего здоровья, финансов и национальной безопасности? Придется разворачивать целую отдельную сферу по изучению глубоких возможных последствий и рисков с последующими смягчениями ошибок в коде, нападений и заражений.

Применительно к военным системам, риски очевидны; но коммерческие продукты, разработанные ИИ, могут произвести широкий спектр неожиданных негативных последствий. Одним примером может быть разработка химических веществ для снижения количества углерода в атмосфере. Агентство по охране окружающей среды испытывает такие продукты на пример возможной опасности, пытаясь обнаружить ее до тех пор, как они будут выпущены. Но если ИИ будет проектировать продукты, которые пройдут тесты, будет ли он делать действительно безопасные продукты или только те, которые могут обойти тесты?

Один из способов начать решать этот вопрос — создать ИИ и наблюдать за его поведением в упрощенных условиях, когда люди будут по-прежнему умнее. RAND разработал симуляцию сценария с атмосферными удобрениями, который включал глобальную температуру и население спустя 75 лет в будущем. Когда ИИ дали три химических вещества для изучения, EPA смогло частично ограничить опасности. Но как только ИИ предоставили агенты замедленного высвобождения, распространенные в среде удобрений, он полностью обошел защиты и начал снижать число производителей углерода в окружающей среде.

Те же типы вопросов могут существовать для всякого рода потенциально опасных продуктов, вроде тех, что попадают в список урегулирования со стороны государственных инстанций, FDA, EPA и прочих. Стоит также отметить, что при разработке сценария не учитывались опасности со стороны продуктов, которые ИИ может разработать за пределами США.

Можно ли полностью устранить риски, связанные с ИИ? Если коротко, то нет: но ими можно управлять, причин бить тревогу нет. Лучшим способом обеспечить надлежащие гарантии было бы ограничить сам ИИ: как минимум разработать протоколы испытания дизайна алгоритмов ИИ, улучшить кибербезопасность, качественные стандарты одобрения. Такая защита должна быть тщательно спроектирована для каждой отрасли или отдельного применения, с привлечением множества экспертов ИИ, которые понимают технологии, нормативно-правовую базу и конкретную отрасль или применение. В то же время нормативно-правовая база должна создаваться так, чтобы не затормозить развитие и инновации.

ИИ необходимо войти в общественный и политический дискурс, развязать реальную дискуссию между техническими гуру и политиками о последствиях, применении и этике искусственного интеллекта. Специализированный ИИ для создания продуктов может быть возможным уже сейчас, но очень важно понять, будут ли его действия вредными, и на этот вопрос не могут пока ответить ни системы ИИ, ни их разработчики.

Ответ на этот вопрос может показаться невозможным, но надежда есть. Во-первых, рисками ИИ, как и большинства технологий, можно управлять. Но необходимо начать диалог. Во-вторых, в отличие от голливудских ИИ, эти машины создаются для работы на человечество, а не против него. Потребуется армия экспертов в области ИИ, чтобы заставить его работать таким образом, но поиск мер предосторожности может и должен начаться уже сейчас. ИЛЬЯ ХЕЛЬ

Комментариев нет:

Отправить комментарий